随着深度学习技术的飞速发展,生成式预训练技术逐渐成为人工智能领域的研究热点。GPT(Generative Pre-trained Transformer)作为这一领域的代表性成果,已经取得了令人瞩目的成绩。本文将从GPT的发展历程、技术原理以及未来可能性三个方面展开探讨。

一、GPT的发展历程

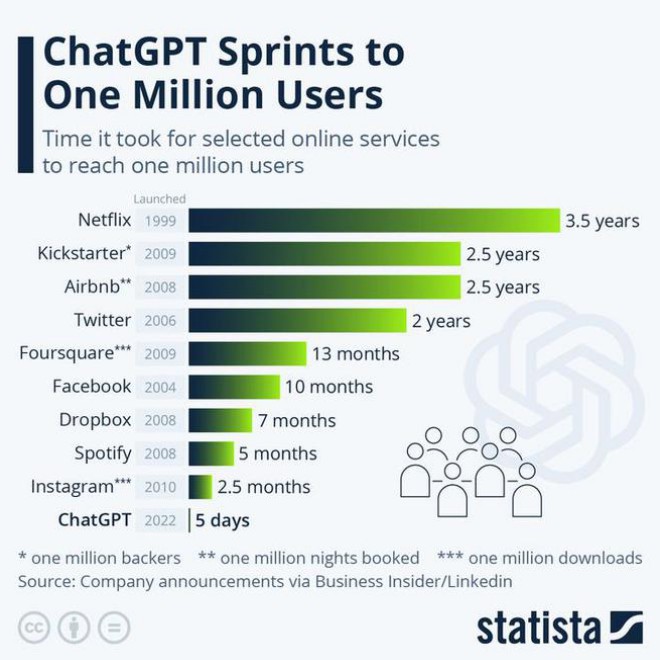

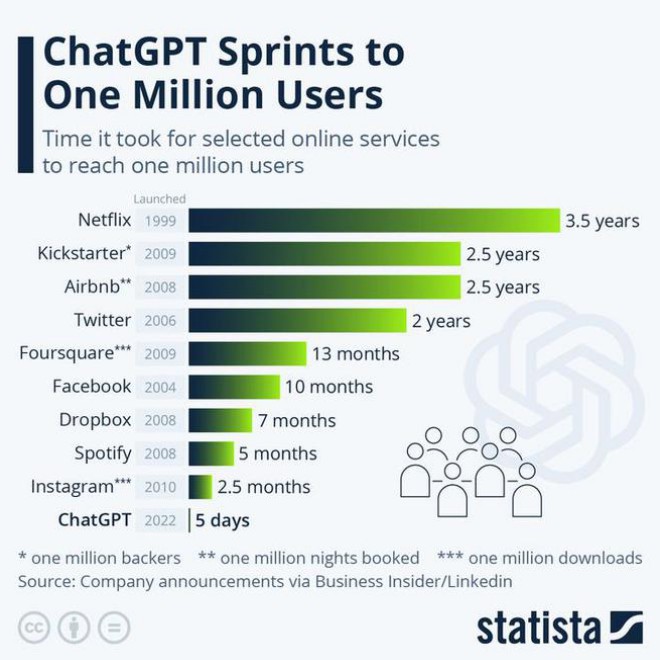

GPT最早由OpenAI团队于2018年提出,它是基于Transformer架构的生成式预训练模型。GPT-1模型在语言建模、文本生成等任务上取得了显著的效果。随后,GPT-2、GPT-3等版本相继问世,模型参数从1.17亿增长到1750亿,性能也得到了极大的提升。GPT-3在多个自然语言处理任务上取得了人类水平的表现,引发了广泛关注。

二、GPT的技术原理

GPT的核心技术是基于Transformer的生成式预训练。Transformer是一种基于自注意力机制的深度神经网络结构,具有较强的并行计算能力。GPT模型通过大量文本数据进行预训练,学习文本中的概率分布,从而具备生成文本的能力。

1. 预训练目标:GPT的预训练目标是最小化给定输入文本的负对数似然,即最大化输入文本的概率。

2. 损失函数:GPT使用交叉熵损失函数进行训练,以衡量模型生成的文本与真实文本之间的差距。

3. 生成策略:GPT采用自回归生成策略,即根据已生成的文本序列逐步预测下一个词。

4. 微调:GPT在预训练完成后,可以通过微调的方式适应特定任务,提高模型性能。

三、GPT的未来可能性

1. 模型规模的扩大:随着计算能力的提升,未来GPT模型的规模将继续扩大,性能也将得到进一步提升。

2. 多模态生成:GPT目前主要处理文本数据,未来有望扩展到图像、音频等多模态数据,实现跨模态生成。

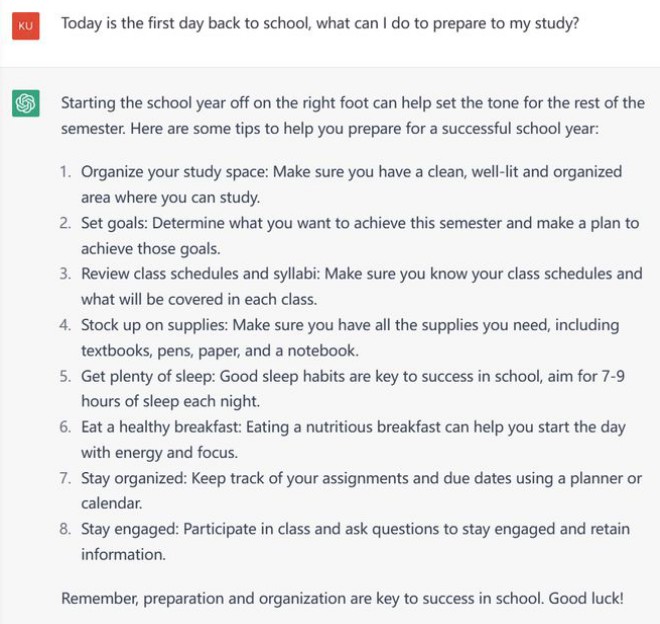

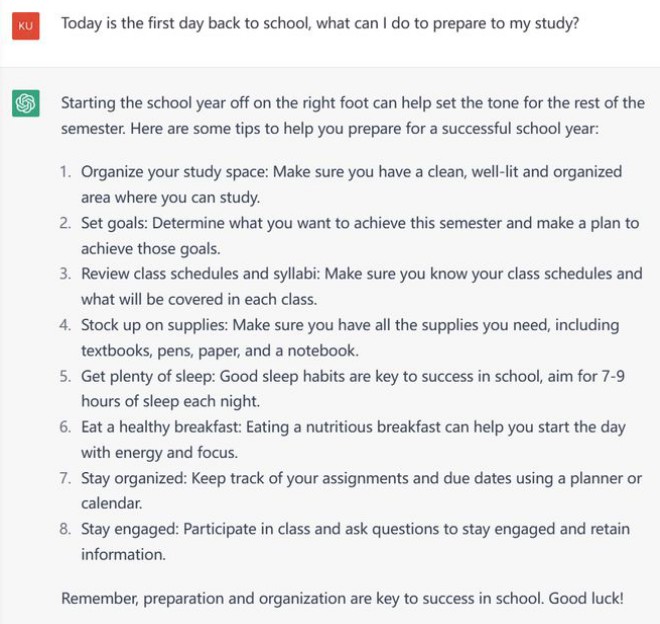

3. 任务适应性:通过微调等策略,GPT可以适应各种自然语言处理任务,有望成为通用型人工智能助手。

4. 伦理与安全:随着GPT在各个领域的应用,伦理与安全问题日益凸显。如何确保GPT生成的文本符合道德规范,防止滥用,将是未来研究的重点。

5. 可解释性:GPT作为一种黑箱模型,其内部机制难以解释。提高GPT的可解释性,有助于我们更好地理解模型的工作原理,提高模型的可信度。

总之,GPT作为生成式预训练技术的代表,具有广泛的应用前景。在未来,随着技术的不断进步,GPT将更好地服务于人类社会。